11 July 2023

我们非常激动地发布 Xorbits Inference,一个企业级大规模模型推理框架。

2024.01.30

Chat2DB + Xinference:本地化 Text2SQL 方案

本文主要介绍了如何基于 Chat2DB 和 Xinference 打造一个基于本地 LLM 的 Text2SQL 方案,使用 Qwen-Chat 14B 作为LLM,详细梳理了安装与部署 Xinference,以及如何通过Chat2DB 进行数据库查询的具体步骤

2024.01.15

Xinference 0.7.0 至 0.8.0 版本功能全面升级!

0.7.0 版本至 0.8.0 版本的 Xinference 重要功能 Highlight

2024.01.09

FastGPT + Xinference:一站式本地 LLM 私有化部署和应用开发

在这篇文章中,我们将演示如何通过 Xinference 来部署一个开源 LLM——Qwen-14B,并且在这个模型基础之上,使用 FastGPT 提供的可视化工作流编排,来构建一个能够查询天气 API 来回答问题的聊天应用。

2023.12.19

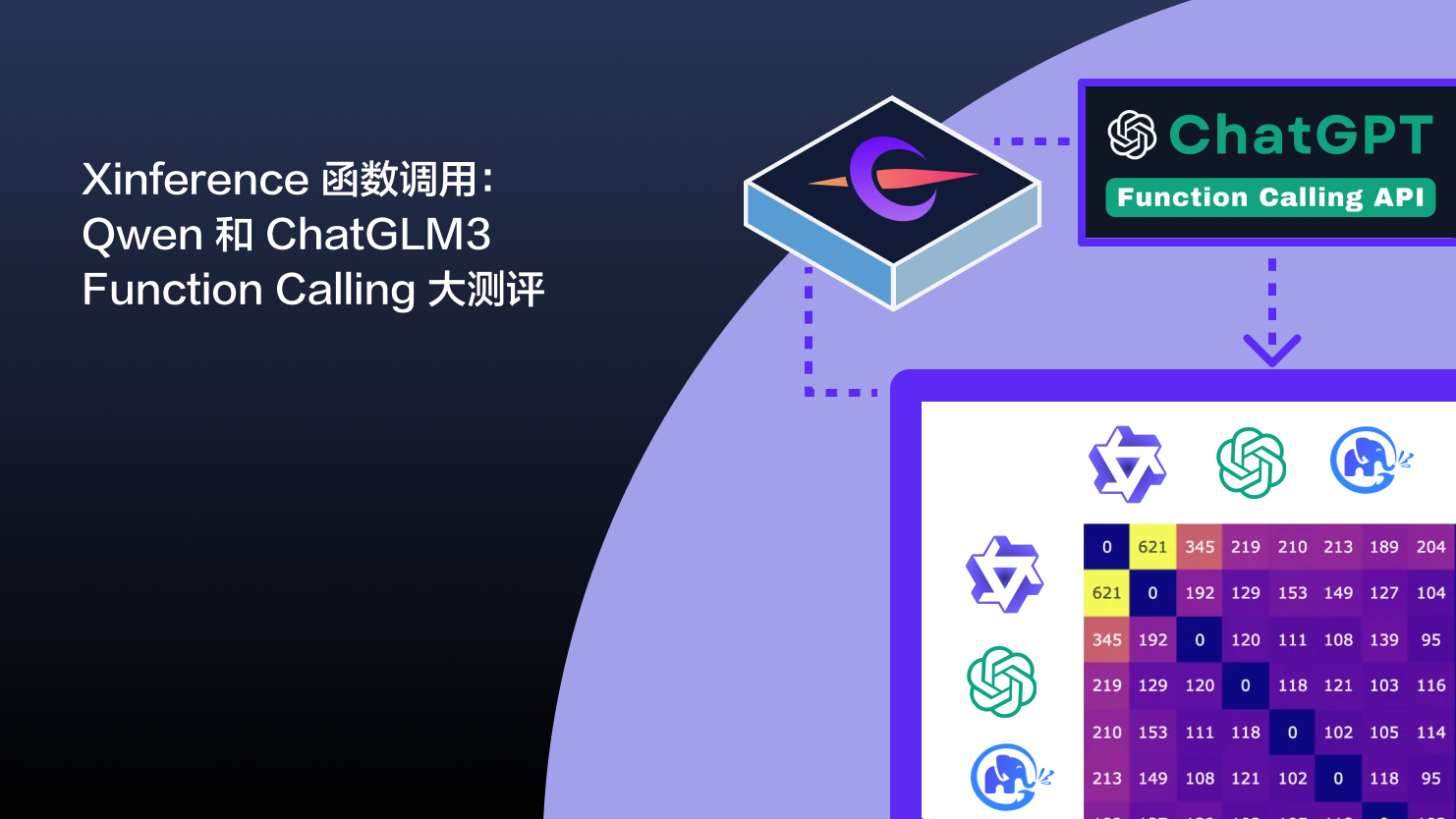

Xinference 函数调用:Qwen 和 ChatGLM3 Function Calling 大测评

Xinference 为中文开源大型语言模型 Qwen 和 ChatGLM3 引入了类似 OpenAI 的函数调用能力,提升了模型与外部API的互动性能,拓展了模型的应用范围。本将演示 Xinference 部署模型和使用函数调用方法,并评估多个大型语言模型的性能。

2023.12.13

未来速度公司荣获2023 NVIDIA 初创企业展示“荣耀企业”称号

备受瞩目的科技创新企业“未来速度公司”在2023年的NVIDIA初创企业展示中荣获“荣耀企业”称号,凭借其在人工智能和高性能计算领域的卓越表现获得业界高度认可。

2023.11.24

未来速度助力浙大一院提升临床医学大数据分析效率

随着医疗信息化的深入发展,面对日益庞大的临床医学数据,有效的数据分析成为了挑战。在这一领域,未来速度公司与浙江大学一院生物医学大数据中心合作,共同推进临床医学大数据的分析和应用。 在最近举办的专题培训中,未来速度公司 CTO 何开圣详细介绍了面对大规模临床数据分析时的性能优化策略。

2023.11.23

Qwen 本地部署与 LangChain 应用开发全攻略

在这篇文章中,我们将深入了解大型语言模型(LLM)在应用开发中的作用,主要演示如何通过 Xinference 来部署一个开源 LLM——Qwen-14B,并且在这个模型基础之上,使用 LangChain 来构建一个能够阅读文档并回答问题的应用。

2023.11.03

未来速度荣誉参展Data & AI Con Shanghai 2023

2023年11月18日未来速度公司即将亮相业内备受瞩目的盛事——Data & AI Con Shanghai 2023。本次大会以“数智云聚 万象创生”为主题,由上海白玉兰开源开放研究院、人工智能开源软件发展联盟联名主办,并由示说承办。会议将在上海圣诺亚皇冠假日酒店举行,届时将集结数据与人工智能领域的精英共襄盛举。

2023.10.29

智能化软件工程新范式讨论——CCF中国开源大会圆满落幕

近日圆满闭幕的CCF中国开源大会上,以“大模型时代的智能化软件工程新范式”为主题的分论坛成功举行,杭州未来速度科技有限公司在其中发挥了重要作用。此次论坛由中国计算机学会(CCF)组织,汇聚了业内多位顶尖专家,共同探讨大模型带来的软件工程革新及未来发展。