满足你所有需求的高性能推理服务平台

模型全生命周期管理、多推理引擎、异构 GPU、高吞吐和高可用、高效调度策略

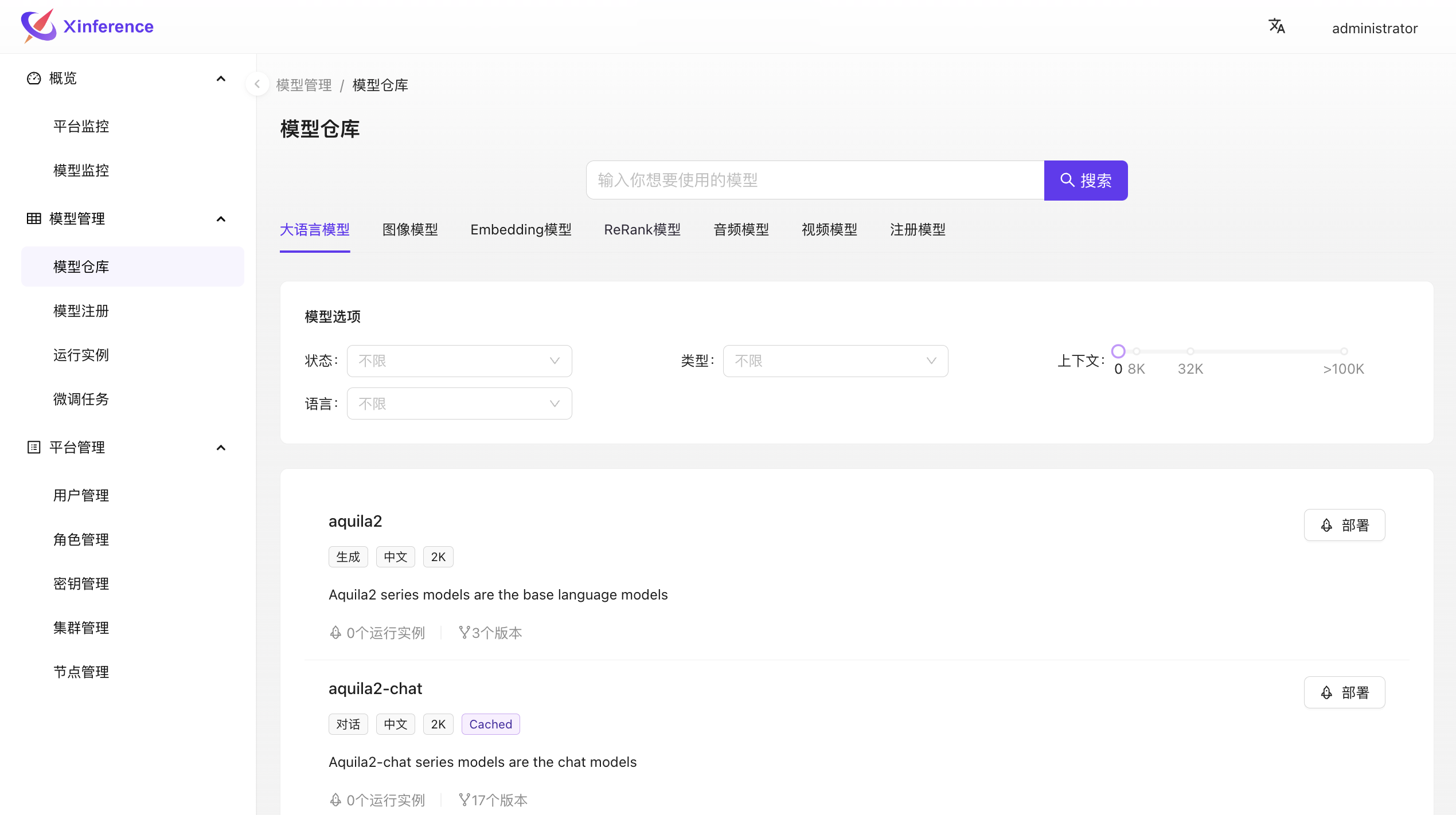

支持的模型丰富

提供100+最新开源模型,从文本语音视频到 embedding/rerank 模型,始终保持最快适配。

广泛的硬件支持

支持多种硬件平台,支持国产 GPU,包括华为昇腾、海光、天数等。可同时支持多种硬件共同服务

生态丰富

多种主流开发框架已经原生支持 Xinference,包括 Langchain、Dify、Ragflow、FastGPT 等

多推理引擎支持

优化支持多种主流推理引擎,包括 vLLM、SGLang、TensorRT、Transformers、MLX、LMDeploy 等

分布式高性能

原生分布式架构,可轻松水平扩展集群,支持多种调度策略适应低延迟、高上下文、高吞吐等不同场景

更多企业级特性

支持用户权限管理、单点登录、批处理、多租户隔离、模型微调、可观测等众多企业级特性